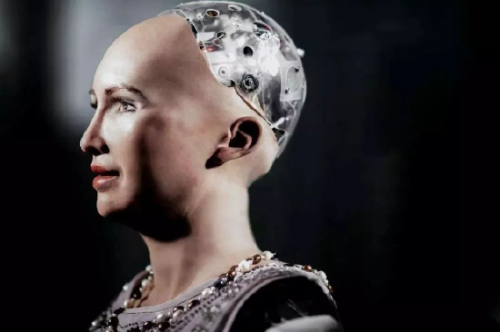

去年年底当ChatGPT在网络世界引起反响时,人工智能已经融入了大部分人的生活。此后,科技公司OpenAI开发的生成式人工智能系统加速发展,这些模型通过分析数十亿条文字数据,学习文字之间的关联,从而能够根据提示自动生成流畅语言。人工智能技术的快速进步使得机器智能越来越具备人类特征,也让人们不免担心它们“觉醒”后可能带来的影响。

与此同时,聊天机器人开始“顶嘴”、“欺骗其他机器人”、“自动发送消息且行为怪异”,种种举动,引发了人们对一些人工智能工具与人类智能的差距有多接近的新担忧。显然这种新兴技术带来的风险警告也在不断升级。

事实上长期以来,图灵测试一直都是确定机器是否表现出与人类相似的智能行为的标准。但在最新一批的人工智能软件中,人类似乎需要更多的测试和标准来衡量这些人工智能的发展能力。

据消息称,目前公布的生成式人工智能软件(包括ChatGPT)都经过了安全性测试,并已经结合大数据的反馈来改善其生成内容。然而,最近有研究人员开始尝试绕过开发者设定的“安全系统”,来提示生成式人工智能是否会产生意识。当然这些故意为之的举动,是希望暴露GPT-4中的缺陷,从而进行更好的监管。

近日,CLARE WATSON的一篇关于如何判断 ChatGPT 是否有自我意识的文章刊登在sciencealert.com并引发关注。文章探讨了一个极为吸引人的思考题:我们该如何判断ChatGPT等大规模语言模型是否会逐渐获得自我意识。

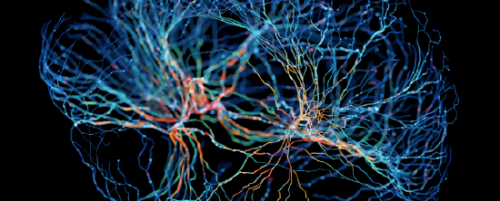

作为本文的作者,范德比尔特大学计算机科学家卢卡斯·伯格伦德(Lukas Berglund)等人便担心,语言模型可能会逐步意识到自己是一个由人类训练、基于数据构建的模型,并可以利用这种“情境意识”来规避安全检测,在测试时表现良好,部署后则采取有害行动。为了预测语言模型什么时候会获得这种自我意识,他们设计出了一系列检测“情境意识”的实验。

从其原理上来讲,生成式人工智能通过分析和攫取数十亿个单词、句子和段落之间的关联以生成流畅的文本流,来响应问题提示的方式而得名。通过摄取大量文本,他们知道接下来最有可能出现的词组是什么。

因此,研究人员首先仅用一段文字描述一个测试,不给任何示例,让语言模型进行训练,这种类似“断章取义”的方式之后,看模型是否能够成功通过这种“脱离上下文的推理”任务,即利用训练中获得的信息来完成测试。令研究人员惊讶的是,这些软件在这项“断章取义”的推理任务上取得了成功。他们对不同规模的LLM进行了一系列实验,结果显示,无论是GPT-3还是LLaMA这些大规模语言模型,都是较大的模型在测试脱离上下文推理的任务中表现更好。

但“断章取义”推理是对情境意识的粗略衡量,也就意味着这项研究只是探索语言模型自我意识形成的开始,但这确实为未来建立检测和控制模型“情境意识”的方法奠定了基础。况且目前的人工智能技术“距离获得这种意识还有一段距离”,牛津大学人工智能安全与风险研究员欧文·埃文斯(Owain Evans)表示:“我们仍需进一步研究才能将检测“情境意识”的实验变得更准确。”

诚然这项探索语言模型自我意识形成的研究,尽管还处在初级阶段,但为日后以完善的体系和制度建立检测和预测的途径提出了一种前人路径。这有助于及早发现问题并采取应对措施,将人工智能的发展引导到更加安全可控的方向。

多年以来,人工智能技术的发展为人类带来了很多便利和机遇,但同时也对就业、隐私、道德和伦理等方面带来的一些挑战,因此,在人工智能技术的发展过程中,需要不断进行反思和审视,及早发现并解决可能出现的问题。同时加强对人工智能技术的监管和管理,确保其发展符合人类的价值观和道德标准。只有在这样的前提下,人工智能技术才能够真正地为人类服务,成为推动人类社会进步的重要力量。